intelligence artificielle: la problématique

l’idée

L’intelligence artificielle dispose de son scénario extrême qui a pour nom “la singularité technologique“. Il nous parle de ce moment supposé proche où la machine, devenue plus intelligente que l’humain, va le dominer (on se reportera à Wikipédia pour en savoir davantage là-dessus), et ce, sur la foi d’extrapolations à partir de la loi de Moore (voir «loi de Moore: les illusions fonctionnelles du futurologue»). Cette “théorie“ renvoie à ce qui a été évoqué dans un précédent billet: «pourquoi les futurologues ont-ils besoin du totalitarisme?».

En pratique, n’existent aujourd’hui que des robots matériels ou immatériels, affublés d’algorithmes complexes les dotant de comportements conditionnels, d’aptitudes évoluées, mais néanmoins limités à l’exécution de missions pour lesquelles ils ont été programmés. L’idée “d’intelligence artificielle“ relève donc, “pour l’instant“, de la spéculation ou de l’abus de langage. Mais que lui prédire pour demain?

la perception artificielle

Des détecteurs spécialisés naissent et s’affinent quotidiennement. Tout ce qui peut se percevoir sera perçu par les robots: tout ce que les animaux parviennent à identifier, toute forme de signal, toute donnée intervenant dans sa composition, tous les types d’ondes et de rayonnements, tous les éléments chimiques ou biologiques (solides, liquides ou gazeux), toute présence de l’inerte et du vivant, tout mouvement global ou particulier … des yeux ou de l’expression d’un visage. Les capacités de perception des robots vont rapidement accéder au plus haut niveau de sophistication.

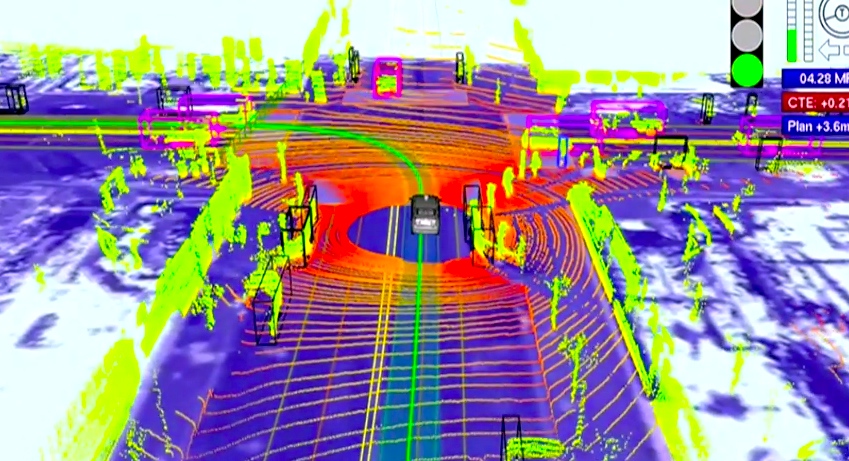

Comment une «Google car» voit son environnement

perception-mémorisation-comparaison

Le “cloud“ aidant, un ordinateur même miniaturisé dispose aujourd’hui de possibilités de mémorisation illimitées. L’intelligence artificielle va donc pouvoir théoriquement prendre en charge tout ce qui découle de la mise en œuvre du couple perception-mémorisation comme les opérations suivantes (… et leurs enchainements):

identification (perception et correspondance mémorisée, cohérence perceptive globale et identification d’anomalies)

classement, tri (classement selon tout type de descripteurs, création de catégories)

statistiques (évolutions, corrélations, probabilités, d’où certaines aptitudes prédictives (cycles, enchainements de séquences…)

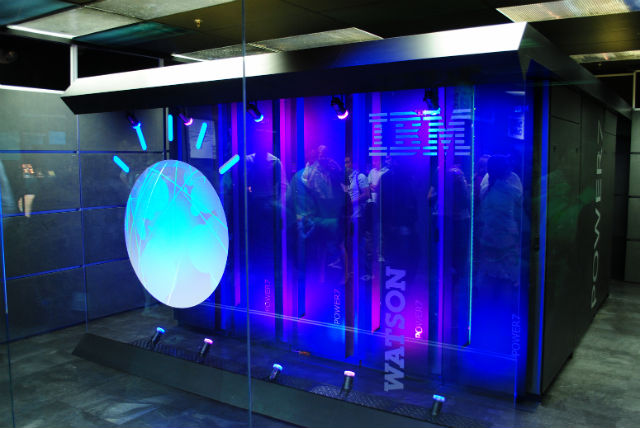

L’intelligence artificielle est donc constituée d’algorithmes complexes alimentés en données par des séries de comparaisons issues du couple perception-mémorisation. Il en découle deux conséquences paradoxales: son principe algorithmique basée sur la comparaison est constant, simple pour ne pas dire simpliste, mais il la rend inaccessible à toute forme d’intelligence connue dans son domaine d’excellence (on se référera, par exemple, aux étonnantes possibilités de Watson, l’ordinateur d’IBM)

l’intelligence artificielle est-elle une intelligence?

intelligence et perception

L’intelligence artificielle s’appuie sur des capacités perceptives inégalables alors que de nombreuses théories insistent sur les liens intimes qu’entretiennent perception et intelligence. Ainsi le physiologiste Charles Scott Sherrington, futur prix Nobel en 1932, a proposé la notion de précurrence (1906) pour expliquer l’émergence de l’intelligence dans le monde animal. Selon lui, les facultés de perception à distance (vue, ouïe, odorat, par opposition aux perceptions par contact), en offrant à l’animal un laps de temps utilisable pour l’anticipation face à l’attaque d’un prédateur, l’auraient amené à “penser son comportement“ et à dépasser ainsi la réaction de pur réflexe.

On constate que les animaux supposés dotés d’une intelligence supérieure (l’homme, les grands singes, les rats…) disposent effectivement de plusieurs modes de perception à distance. Pourtant, ceux-ci ont la particularité paradoxale de ne pas être très performants.

L’intelligence pourrait donc provenir précisément de cette mise en concurrence permanente de modes de perception imparfaits, celle-ci exigeant un recours incessant à l’interprétation.

L’intelligence, définie comme une aptitude à gérer le doute, apparaitrait donc indissociable… de la possibilité de se tromper. Cette hypothèse de relation intime entre l’intelligence et le doute rejoindrait celle formulée par Bergson:

L’homme est le seul animal dont l’action est mal assurée, qui hésite et tâtonne, qui forme des projets avec l’espoir de réussir et la crainte d’échouer.

À l’appui de cette idée, on mentionnera qu’un animal doté d’une ouïe ou d’un flair infaillible peut s’autoriser une réponse automatique à un stimulus, le succès de sa fuite ou de sa chasse n’étant pas amélioré par un surplus d’intelligence. Son espèce aura donc évolué sans elle.

Or l’intelligence artificielle s’appuie sur toute une palette de perceptions infaillibles.

la question du sens

L’intelligence artificielle produit du sens à partir de la comparaison d’éléments perçus ou mémorisés selon le schéma:

• perception &/ou mémorisation 01 / perception &/ou mémorisation 02 -> comparaison 01/02 -> production d’un sens

En l’absence de données, il n’y a pas de production de sens.

Pour l’intelligence “humaine“, la recherche du sens est permanente, incertaine, progressive. Elle préexiste à la perception d’informations qu’elle peut orienter le cas échéant. Elle progresse en générant des hypothèses qu’elle modifie au fur et à mesure qu’apparaissent d’autres perceptions ou d’autres hypothèses (rôle de la contradiction, du social, modification du contexte, des croyances ou du point de vue). À l’instar de la nature qui a horreur du vide, l’humain a horreur du doute qu’il a besoin d’essayer de réduire en permanence. L’ordinateur, lui, ne le connaît pas.

pourquoi les robots ne seront jamais intelligents

les 3 carences rédhibitoires de l’intelligence artificielle

l’imagination

La recherche permanente du sens dans un environnement incertain à partir de données insuffisantes, fait de l’interprétation un processus créatif dont l’approche comparative basée sur des règles est totalement dépourvue. On le trouve exprimé de la façon suivante par Albert Einstein (source):

Une personne qui n’a jamais commis d’erreurs n’a jamais tenté d’innover. (…) L’imagination est plus importante que le savoir.(…) L’intelligence n’est pas la capacité de résoudre des problèmes, mais de les poser. Les machines un jour pourront résoudre tous les problèmes, mais jamais aucune d’entre elles ne pourra en poser un.

la métacognition -savoir ce que l’on sait- (w):

Le rat est capable de métacognition. …/… ceci a été démontré par une expérience de Foote et Crystal …/… qui consistait à lui faire entendre des sons, afin qu’il juge si un son était long ou court. Au fil de l’expérience, les sons devenaient de plus en plus difficilement identifiables et discriminables. Les rats avaient deux choix : répondre correctement à la question et recevoir une grosse récompense (ils ne recevaient rien pour une mauvaise réponse) ou éviter la question et obtenir la moitié de la récompense. Lorsque les sons devenaient de plus en plus difficiles à classer, les rats choisissaient de ne pas répondre, plutôt que de donner une mauvaise réponse et de ne rien obtenir.

On le voit dans cette expérience, la métacognition est un composant fondamental de la gestion du doute. Un ordinateur ne sait reconnaître que les conditions techniques qui lui permettent ou non de mener à son terme la routine pour laquelle il a été programmé. Il ignore ce qu’il sait et ce dont il est capable.

la conscience de soi

même source.

Sue Savage-Runbaugh observa avec l’aide de Kanzi, singe bonobo, que les primates sont capables de mentir …/… Une expérience du chercheur Bernd Heinrich prouve que les corbeaux réussissent à se berner les uns les autres

L’aptitude à élaborer des stratégies individuelles suppose une conscience évoluée de l’autre et surtout de soi, sanctionnée par le test du miroir où l’animal est marqué avec de la peinture à un endroit impossible à observer directement

À ce jour, seuls les grands singes, le dauphin, l’orque, la pie, le corbeau et l’éléphant ont passé ce test avec succès

Ce test suppose une double performance puisque l’animal:

• doit avoir conscience de sa propre existence

• doit considérer que cette image qui ne fait pas de bruit et qui n’a pas d’odeur… c’est lui… ce qui suppose une capacité d’interprétation complexe à partir de son propre système perceptif.

l’exemple du recours à l’outil non dédié

L’utilisation d’un outil non dédié (une branche, un caillou…) se trouve au carrefour de ces différentes aptitudes.

• conscience de ses propres limites (métacognition) pour identifier un besoin d’outil

• adaptation à sa propre morphologie et à ses capacités de mouvement (conscience de soi)

• capacité à identifier dans l’environnement ce qui peut s’assimiler à un outil et/ou transformation à lui appliquer pour qu’il le devienne (imagination)

Les grands singes et les corvidés (corbeaux, pies…) sont capables de ces opérations mentales. Les machines… non.

l’impossible accès à l’auto-dépassement

L’intelligence artificielle ne parviendra jamais à produire les conditions de sa propre progression, rôle généralement dévolu à ce qu’on appelle la dialectique (w)

Elle désigne un mouvement de la pensée, qui se produit de manière discontinue, par l’opposition, la confrontation ou la multiplicité de ce qui est en mouvement, et qui permet d’atteindre un terme supérieur, comme une définition ou une vérité.

La richesse de cette confrontation est bien résumée par la phrase suivante, mentionnée en commentaire de l’article déjà cité

Je voudrais citer un article intitulé « Le biologiste dialecticien » de Richard Levins et Richard Lewontin : « Ce qui caractérise le monde dialectique sous tous ses aspects est qu’il est constamment en mouvement. Les constantes deviennent des variables, les causes deviennent des effets, et les systèmes se développent, détruisant les conditions qui leur ont donné naissance. Même les éléments qui apparaissent stables sont des forces en état d’équilibre dynamique qui peuvent soudain se déséquilibrer.

Ce qui nous amène au célèbre “plan dialectique“ (w)

… dont la structure est « thèse-antithèse-synthèse » : je pose (thèse), j’oppose (antithèse) et je compose (synthèse) ou dépasse l’opposition.

Ce qui suppose la confrontation d’interprétations diverses et surtout la production d’une synthèse, étape la plus créative du processus, qui restera toujours inaccessible à l’intelligence artificielle.

l’intelligence artificielle pourra-t-elle se substituer à l’intelligence?

les comportements anthropomorphiques

On peut programmer un robot pour qu’il identifie dans un film une représentation de la misère et qu’il laisse glisser une larme de ses yeux quand il la détecte. Cela ne crée pas un robot sensible, mais produit l’illusion d’une sensibilité. Il en va de même pour certaines représentations de l’intelligence. Ainsi, tout ce qui découle de la programmation directe d’un comportement ne peut se prétendre “intelligent“. Il s’agit d’un simple asservissement du même type que celui que l’on obtient d’un animal par le dressage.

intelligence & langage

Les spécialistes en éthologie cognitive (w) considèrent que l’existence d’un langage constitue un indicateur d’intelligence évoluée (grands singes, dauphins …), même s’ils lui préfèrent généralement le terme moins anthropocentrique de “communication“. Que peut-on attendre des machines dans ce domaine?

Les robots ont évidemment la capacité de communiquer avec l’homme par programmation d’interface (voyants, messages textes, icônes, parole…), sinon, que pourrait-on en faire? Mais une communication entre eux, indépendante de leurs algorithmes, est-elle imaginable?

Très certainement. Un robot a la capacité de percevoir des signes d’activités chez un autre robot (ondes, rayonnements, bruits, mouvements…), d’associer ces signes à des effets sur l’environnement, puis d’établir des corrélations à partir de données stockées en mémoire. Ce principe, évidemment réciproque, pourrait faire des indicateurs de fonctionnement eux-mêmes une forme de langage inter-machines non directement programmé, simplement appuyé sur le couple détection-comparaison. La possibilité existerait même de convertir, à la volée, ces échanges en langage humain (voir production d’illusion ci-dessus). Il s’agit d’un langage d’un nouveau genre mais qui n’ajoute rien à l’aptitude globale.

les ondes cérébrales

Les robots doivent être considérés comme potentiellement capables de produire tous les signaux qu’ils ont la faculté de détecter: les ondes cérébrales en font partie. Ceci parle beaucoup à notre imagination, mais échanger par ondes cérébrales suffit-il pour être considéré comme intelligent?

(ci-dessous un fauteuil roulant pilotable par la pensée –source-)

… Communiquer par ondes acoustiques suffit-il pour être considéré comme musicien?

autour de l’idée de création

Le principe fondamental par lequel l’intelligence artificielle espère se substituer à l’intelligence humaine est celui de l’accumulation ultra-rapide de boucles de test (de plus en plus de tests de plus en plus vite selon la loi de Moore)… qui a permis à l’ordinateur de devenir imbattable aux échecs… et à Jeopardy (voir Watson d’IBM).

À l’opposé de ce modèle rationnel, les algorithmes offrent également la possibilité d’intégrer des éléments aléatoires à partir desquels associer ou mixer des graphismes ou des sons.

Capable d’une forme de création dans un domaine totalement normalisé, dans le premier cas, et également dans un domaine totalement libre, dans le second, l’intelligence artificielle serait-elle apte à toutes les créations intermédiaires?

Certainement pas. Chacune de ces deux extrêmes s’appuie sur des routines différentes, spécifiques… et inconciliables. L’irruption de l’inédit dans le normalisé ou de l’exigence pratique dans le librement aléatoire rend totalement caduque la routine initiale.

Ainsi, la dernière difficulté que saura résoudre la voiture sans pilote sera d’entrer sur une autoroute ou une voie prioritaire saturée et se mouvoir dans un embouteillage… c’est à dire d’enfreindre le Code de la route, chose que nous sommes amenés à faire quotidiennement.

À l’inverse, la création exigeante (faire du nouveau complexe) sur une base fonctionnelle (c’est-à-dire non aléatoire), comme par exemple dans le domaine de l’architecture, du design ou du vrai journalisme, restera inaccessible à la machine.

intelligence artificielle et progrès

l’intelligence artificielle et le vivant

On évoque aujourd’hui les possibilités de modéliser le cerveau (source technologyreview) voire de s’appuyer sur le vivant (source humanoïdes) afin de s’y alimenter en “conscience“ et en “imagination“. Pourtant, même si l’on “capte du cerveau vivant“ pour alimenter l’intelligence artificielle, même si l’on résout les problèmes physiologiques (rejets, phénomènes de compensation…), même si l’on s’appuie sur l’architecture des neurones, même si l’on sait assurer la maintenance de tels systèmes, demeurera un inconciliable fondamental, autant technique que métaphysique: l’adaptation à un monde de vérité ou à un monde du doute, quand toute aptitude nouvelle à aborder l’un s’opère au détriment de l’aptitude à aborder l’autre. Donner des pattes à un poisson n’en fera pas un grand marcheur, mais à coup sûr un mauvais nageur.

Que resterait-il d’un robot qui douterait de son système de détection?

les rendements décroissants

On admet pour l’humain que le simple ne donne pas linéairement accès au complexe. Pourtant le “techno-scientisme ambiant“ nous amène à ne pas appliquer ce principe à la machine. Ses progrès illimités dans un domaine particulier, à partir d’un premier résultat positif, semblent toujours relever de l’évidence. Qu’un ordinateur sache rédiger un tweet et on l’imagine déjà écrivain.

S’élever dans la complexité exige, le plus souvent, un changement de paradigme et dans tous les cas un investissement croissant. Ceci est vrai dans tous les domaines. Plus on se rapproche du haut niveau, plus les gains de performance s’avèrent difficiles… et coûteux. Or, à l’heure actuelle, 1000 ordinateurs et 16000 processeurs restent nécessaires pour reconnaître un chat (voir l’expérience de GoogleX)

Les systèmes obtenus par les progrès de l’intelligence artificielle vont devenir de plus en plus sensibles et vulnérables. Leur maintenance sera de plus en plus difficile. Leurs bugs de plus en plus atypiques et incompréhensibles. Ce qui signifie que même si des possibles de laboratoire inattendus offraient aux machines un accès à des niveaux de complexité supérieurs, il leur faudrait alors composer avec cette loi des rendements décroissants, qui mettrait en cause leur faisabilité concrète et l’intérêt qu’un acteur économique pourrait trouver à les exploiter.

L’intelligence artificielle va rester un abus de langage.

Les robots ne sauront jamais faire autre chose que ce qu’ils font déjà (percevoir, mémoriser, comparer) même s’ils le font de mieux en mieux et de plus en plus vite. Ils demeureront des outils extraordinaires, mais ne disposeront jamais d’une intelligence véritable… dont on va progressivement renoncer à les doter.

Cela signifie que les recherches d’optimisations ciblées (robots outils) vont re-prendre le pas sur celles concernant la concentration d’aptitudes (robot démiurge).

Par ailleurs, d’autres voies s’ouvrent déjà dans les environnements inaccessibles à l’humain comme l’infiniment petit où les robots vont entrer dans l’intimité de la matière et du vivant… pour le meilleur ou pour le pire.

Laisser un commentaire