On ne peut s’empêcher d’y attacher un présupposé de création, c’est pourquoi l’aptitude à rédiger apparait comme la plus troublante des applications de l’IA aux métiers du texte. Pourtant, à beaucoup d’égards, c’est la plus simple. La rédaction concerne actuellement la “mise en texte” de situations ou de données types, généralement liées à des variables numériques. Le “sens” préexiste et n’a pas à être recherché. L’AFP, Le Monde, la Bibliothèque de France, Radio France ou Les Echos ont déjà recours aux services de la société Syllabs . Narrative Science, Automated Insights ou Yseop , sont autant de sociétés d’ores et déjà opérationnelles dans le même registre… à la différence de OpenAI (*), qui, visant des applications plus ambitieuses , se heurte au vrai problème: la recherche automatique du sens… objectif d’autant plus difficile à atteindre par la machine, que pour elle… le sens n’existe pas.

[(*) OpenAI est une société d’Elon Musk. Il sera donc prudent de garder un minimum de distance vis à vis de ses annonces].

la force brute et l’algorithme

Février 1996, le Deep Blue d’IBM bat le champion du monde d’échecs Garry Kasparov. Derrière cette prouesse apparente d’intelligence artificielle, le recours à une impressionnante force brute: l’analyse par Deep Blue de 300 millions de coups par seconde. L’algorithmique, supposée représenter l’intelligence de la machine, n’est certes pas absente, elle permettra, dix ans plus tard de battre le champion du monde Vladimir Kramnik avec une capacité d’analyse… “réduite”… à 8 millions de coups par seconde (… tout de même). Actuellement, et sans doute pour longtemps, l’IA ne peut s’envisager en dehors d’un traitement massif et “inintelligent” de données, au moins en phase préalable. On y retrouvera déclinés, les principes algorithmiques déjà entrevus dans un précédent billet (“deep learning: ce qu’une machine ne pourra pas apprendre”) et plus largement développés dans ce remarquable travail d’Olivier Ezratty .

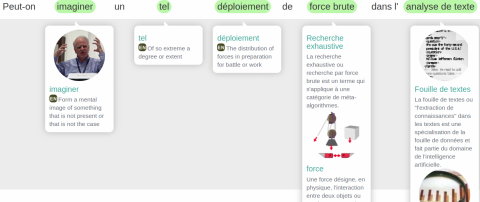

BabelNet est un réseau sémantique multilingue et une ontologie lexicalisée. BabelNet a été créé en intégrant automatiquement la plus grande encyclopédie multilingue – c’est-à-dire Wikipédia – avec le lexique de la langue anglaise le plus connu – WordNet.

On trouvera ici le résultat pratique et multilingue de cette démarche, et ci-dessous l’image d’un test réalisé à partir d’une des phrases précédentes:

Nous allons retrouver une application beaucoup plus extravagante de la force brute appliquée au texte à l’université de Carnegie Mellon où dans le cadre du projet NELL (Never Ending Langage Learning ) sont infatigablement scannés depuis une dizaine d’années des millions de textes, aux fins d’établir une base géante de liens sémantiques entre expressions textuelles. Et vous avez bien lu… “Never Ending”… ce qui signifie qu’ils n’ont pas prévu de s’arrêter!

On sait que les recherches très lourdes telles que celles-ci ont pour conditions nécessaires … et surtout suffisantes… l’existence de fonds pour les financer. Et pour NELL, ce n’est pas ce qui manque: Google, Yahoo, la DARPA (Département de la Défense américain) et quelques autres. Mais que faut-il penser de l’hypothèse scientifique sous-jacente qui poserait que l’on puisse accéder aux subtilités du sens par la force brute? Là, il ne s’agit plus d’évoluer sur la base de règles strictes dans l’espace fermé d’un échiquier.

L’élaboration, le maintien et le développement d’énormes bases de données de phrases et de séquences de textes déjà traduites ont certes permis la progression rapide de la traduction automatique. Cependant, ces progrès ont surtout concerné les textes scientifiques et techniques, ce qui introduit une dimension essentielle de la recherche automatique du sens: le préalable des contextes.

les poupées russes du sens

Rien n’a de sens en soi. Le sens est un lien. Le sens ne peut être envisagé que comme découlant d’une mise en relation de mots, de phrases et d’ensemble de phrases. Le contexte est le déterminant principal du sens, en marge des mots eux-mêmes. Si l’on se penche sur les activités de recherche dans ce domaine, comme les thèses universitaires, on constate qu’un accent particulier a été mis de longue date sur la nécessité d’élaborer des typologies pertinentes de textes: typologies par domaines , (juridiques, scientifiques…) ou a portée plus générale (descriptif, narratif, expositif, argumentatif, instructif). Chaque type doit disposer de ses propres marqueurs, termes spécialisés dans le premier cas, prépositions, adverbes et autres indicateurs dans le second cas – temporels pour le narratif – formels et spatiaux pour le descriptif -…etc.

Le type de texte est le premier sous-ensemble identifiable, celui qui va orienter l’interprétation générale. À l’intérieur de ces types, les regroupements de mots vont progressivement distinguer des sous-ensembles, puis d’autres sous-ensembles à l’intérieur ou en interaction avec les précédents. Le sens d’un texte va se trouver progressivement localisé dans un “espace” de plus en plus resserré (le projet NELL pourrait servir à cela).

La machine peut donc “approcher” le sens… du moins dans le cadre de contextes dénués d’ambiguïté (pour le roman ce sera une tout autre affaire… avec ou sans force brute). Adossé à une importante base de données, ce principe va s’avérer satisfaisant dans le domaine de la traduction d’ouvrages techniques… mais encore très insuffisant là où la recherche du sens est la plus complexe: le résumé automatique.

la problématique du résumé

- C’est le sens qu’il faut identifier et restituer de façon correcte dans la forme comme dans le fond.

- Le bon résumé ne reprendra généralement pas directement les expressions présentes dans le texte original, mais des formulations plus synthétiques

- Le résumé pertinent n’est pas le même pour un spécialiste – qui voudra savoir s’il ne s’agit que d’un article de vulgarisation – que pour le non-initié – qui voudra savoir s’il a des chances d’y comprendre quelque chose

- Le résumé doit mettre en évidence la spécificité d’un texte, sans pour autant se tromper dans son sens général

- Cette tâche est extrêmement délicate, même pour l’humain

- On aura un aperçu de sa complexité en explorant quelques productions du RALI, laboratoire spécialisé de l’Université de Montréal

Actuellement, la machine ne sait pas produire de bons résumés (je m’autorise cette affirmation après de multiples essais effectués sur différents textes – dont les miens – notamment avec resoomer).

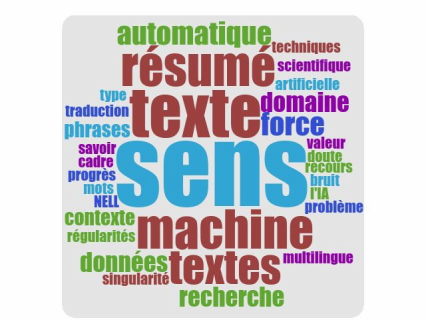

La première approche dans ce domaine pourrait ressembler aux classiques nuages de mots, tels que celui-ci, qui correspond au présent billet, mais la différence serait que la taille des mots n’y serait pas liée à la fréquence de leur utilisation mais à leur “poids sémantique”, beaucoup plus difficile à apprécier.

Est-il envisageable de décliner cette première étape, de façon automatique, jusqu’aux exigences théoriques du résumé, telles qu’elles sont formulées ici, dans l’optique d’une préparation aux concours de la fonction publique?

- Le texte à résumer va devoir être à la fois localisable dans un sous groupe restreint par la présence de marqueurs particuliers, mais présenter sa singularité par l’absence ou la présence incongrue de certains autres. La singularité va se présenter sous les mêmes traits que… l’erreur… ce qui va être un problème réel, notamment pour les résumés de textes traduits.

- D’autre part, l’exigence d’un recours au résumé va devenir d’autant plus aigüe dans les domaines techniques, que la quantité de textes longs y devient très difficile à gérer et que les progrès de la traduction l’amplifient rapidement. Il est donc essentiel que le résumé soit capable de rendre compte de la spécificité d’un article ou d’un rapport… dit autrement de sa valeur informative.

- La valeur informative d’un texte va dépendre de ses contenus “improbables”, mais également du poids sémantique de ceux-ci, qui devra permettre de distinguer l’anecdotique de l’essentiel, l’exemple ou la métaphore du développement fondamental.

- Dans le domaine scientifique, le sens n’existe que dans le cadre d’une théorie. Peut-on imaginer qu’une machine puisse détecter ce qu’il y a de plus essentiel parmi les publications du moment: les prémisses d’un changement de paradigme?

L’intelligence artificielle gère parfaitement les régularités. Or, dans le domaine du texte, la régularité s’assimile à un bruit dans lequel émerge l’information, vue comme le “sens intéressant”, mais qui va se manifester sous la forme d’une “anomalie” dans le bruit ambiant du contexte, exactement comme… le non-sens. Le problème est-il soluble? A priori, oui, en multipliant les balayages. Une anomalie ayant été détectée dans le contexte spécifique du texte, il sera possible de “remonter” à partir d’elle vers de nouveaux groupes sémantiques associés, approcher l’évaluation de l’anomalie et ainsi savoir si elle a sa place ou non dans le résumé. Le processus restera lourd et probablement très incertain. Au final, le sens lui-même ne sera pas identifié, seule une singularité jugée pertinente dans le contenu pourra l’être. Autour du sens, il y a donc des choses que l’IA ne sera sans doute jamais en mesure de réaliser par elle-même.

en guise de conclusion(s) provisoire(s)

L’analyse de la recherche du sens dans les textes amène au même type de conclusion que l’exploitation de la machine dans un tout autre contexte (voir “vers un nouveau paradigme scientifique né du bruit”). On y retrouve, sous des technologies différentes, les possibilités et les limites découlant de l’identification des régularités. On trouvait dans cet autre billet des perspectives potentiellement séduisantes. D’autres, plus sombres, ne doivent pas être négligées, comme dans le cas du traitement massif de données personnelles.

Boris Katz, chercheur au MIT, a passé ses quarante ans de carrière à essayer d’aider les machines à maîtriser le langage (Siri, Alexa…) :

En matière de texte prédictif, la machine sait mieux que vous ce que vous allez dire…/… Parce que nous disons toujours la même chose, il est facile de construire des systèmes qui capturent les régularités et agissent comme s’ils étaient intelligents. C’est la dimension fictive d’une grande partie des progrès actuels.

Les théoriciens du domaine nous disent que c’est son caractère inattendu qui fait la valeur d’une information. Le premier résultat qu’obtiendrait l’intelligence artificielle appliquée au langage serait donc de nous prouver que nos discours sont suffisamment prévisibles pour ne plus poser, à la machine, de problèmes d’interprétation. La machine semblerait ainsi “monter” jusqu’à nous d’autant plus vite, que nous “descendrions” vers elle tout aussi rapidement.

Laisser un commentaire